در حال خواندن: سوگیری الگوریتمها در هوش مصنوعی (Algorithmic Bias) | تهدیدی پنهان برای عدالت دیجیتال

-

01

سوگیری الگوریتمها در هوش مصنوعی (Algorithmic Bias) | تهدیدی پنهان برای عدالت دیجیتال

- خانه

- تحلیل و بررسی

- سوگیری الگوریتمها در هوش مصنوعی (Algorithmic Bias) | تهدیدی پنهان برای عدالت دیجیتال

سوگیری الگوریتمها در هوش مصنوعی (Algorithmic Bias) | تهدیدی پنهان برای عدالت دیجیتال

adminتحلیل و بررسی4 هفته پیش7 بازدید

نقش فزاینده هوش مصنوعی در تصمیمگیریهای اجتماعی

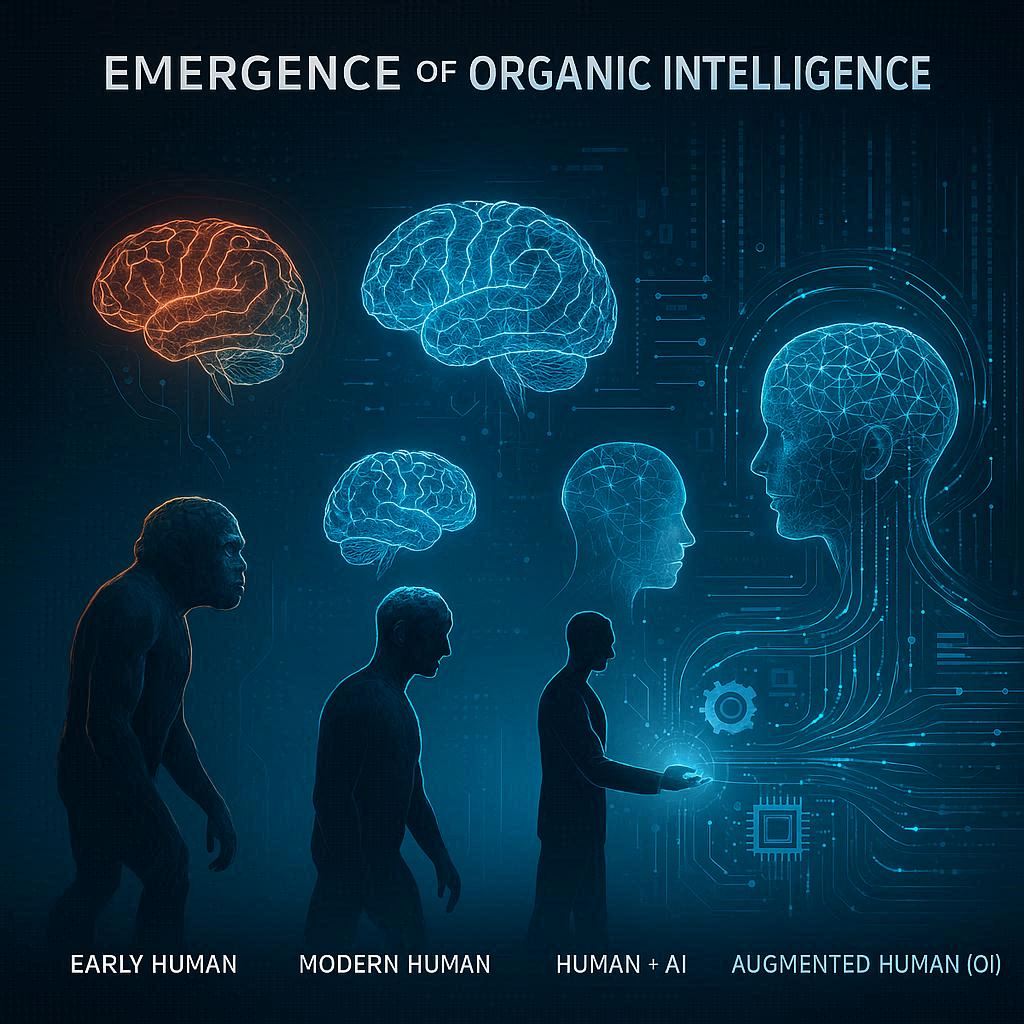

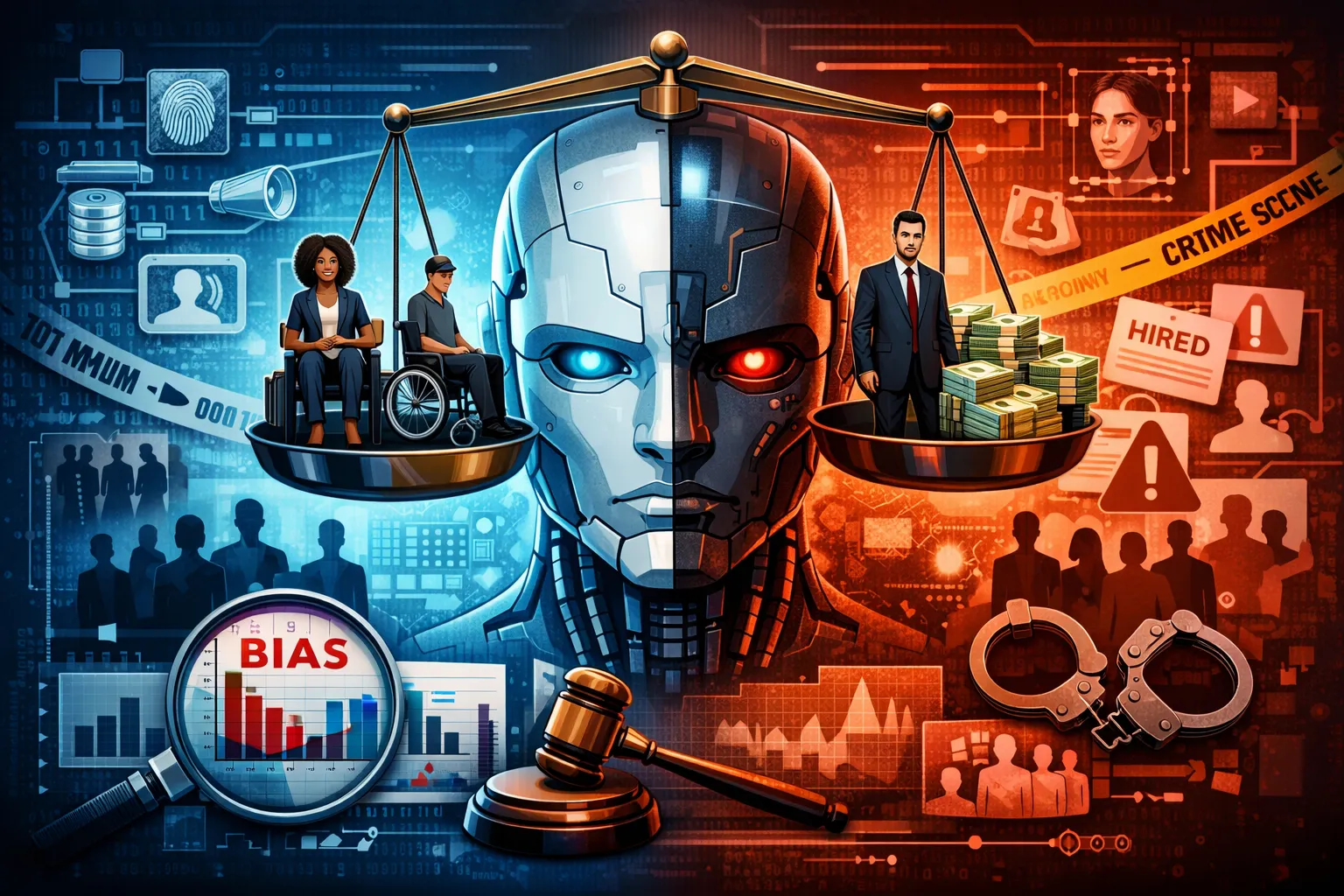

با گسترش شتابان هوش مصنوعی در دهههای اخیر، این فناوری به یکی از عناصر کلیدی در فرآیندهای تصمیمگیری در جوامع مدرن تبدیل شده است. امروزه سیستمهای مبتنی بر هوش مصنوعی در حوزههایی مانند استخدام نیروی انسانی، اعطای تسهیلات بانکی، تشخیص و پیشبینی بیماریها، ارزیابی ریسکهای بیمهای، پیشبینی جرم، مدیریت هوشمند ترافیک، آموزش دیجیتال و حتی تعیین اولویت اخبار در شبکههای اجتماعی نقش مهمی ایفا میکنند. این نفوذ گسترده باعث شده است تصمیمهای الگوریتمی تأثیری مستقیم، عمیق و گاه جبرانناپذیر بر زندگی افراد و گروههای اجتماعی داشته باشند.

در چنین شرایطی، مسئلهی سوگیری الگوریتمها بهعنوان یکی از مهمترین و بحثبرانگیزترین چالشهای حوزه هوش مصنوعی مطرح میشود. زیرا هرگونه جانبداری، خطا یا نابرابری در تصمیمهای الگوریتمی میتواند پیامدهای اجتماعی، اخلاقی و حقوقی گستردهای به دنبال داشته باشد و حتی نابرابریهای موجود در جامعه را تشدید کند.

سوگیری الگوریتمی چیست؟ تعریف و مفهوم Algorithmic Bias

سوگیری الگوریتمی (Algorithmic Bias) به وضعیتی اطلاق میشود که در آن یک سیستم هوش مصنوعی بهصورت سیستماتیک و تکرارشونده نتایجی تولید میکند که به نفع یا ضرر گروههای خاصی از افراد است. این سوگیری میتواند بر اساس ویژگیهایی مانند جنسیت، نژاد، سن، قومیت، طبقه اجتماعی، سطح تحصیلات یا موقعیت جغرافیایی شکل بگیرد.

برخلاف تصور رایج، الگوریتمها ذاتاً بیطرف و خنثی نیستند. آنها محصول تصمیمهای انسانی و دادههایی هستند که از دل ساختارهای اجتماعی استخراج شدهاند. بنابراین اگر جامعهای با تبعیض، نابرابری یا بیعدالتی ساختاری مواجه باشد، این مشکلات میتوانند در دادهها منعکس شوند و در نهایت به الگوریتمها منتقل گردند.

ریشههای سوگیری الگوریتمها در هوش مصنوعی

۱. نقش دادههای آموزشی در ایجاد سوگیری

یکی از اصلیترین عوامل شکلگیری سوگیری الگوریتمی، دادههای آموزشی است. مدلهای یادگیری ماشین با استفاده از دادههای گذشته آموزش میبینند و الگوهای موجود در این دادهها را یاد میگیرند. اگر این دادهها ناقص، نامتوازن یا غیرنماینده باشند، الگوریتم نیز همان الگوهای نادرست را بازتولید میکند.

برای مثال، اگر دادههای استخدام یک سازمان عمدتاً شامل مردان باشد، سیستم هوش مصنوعی ممکن است بهطور ناخودآگاه مردان را گزینههای مناسبتری برای شغلهای آینده تشخیص دهد. این مسئله بهویژه در جوامعی که برخی گروهها بهصورت تاریخی کمتر دیده شدهاند، شدت بیشتری پیدا میکند.

۲. تأثیر تصمیمهای انسانی در طراحی الگوریتمها

علاوه بر دادهها، تصمیمهای انسانی در فرآیند طراحی و توسعه الگوریتمها نقش تعیینکنندهای در ایجاد سوگیری دارند. انتخاب متغیرها، تعیین اهداف مدل، تعریف معیارهای موفقیت و حتی نحوهی برچسبگذاری دادهها همگی میتوانند تحت تأثیر باورها، پیشفرضها و ارزشهای طراحان سیستم قرار گیرند.

برای نمونه، اگر هدف یک الگوریتم صرفاً افزایش سرعت، سودآوری یا کاهش هزینه تعریف شود، ممکن است ملاحظات اخلاقی، عدالت اجتماعی و حقوق انسانی نادیده گرفته شوند. این موضوع نشان میدهد که سوگیری الگوریتمی صرفاً یک مسئله فنی نیست، بلکه ریشهای عمیق در تصمیمگیریهای انسانی دارد.

انواع سوگیری الگوریتمی و شکلهای بروز آن

سوگیری الگوریتمی میتواند اشکال مختلفی داشته باشد. در برخی موارد، این سوگیری آشکار و قابل تشخیص است؛ مانند زمانی که یک سیستم تشخیص چهره در شناسایی افراد با پوست تیره دقت کمتری دارد. در موارد دیگر، سوگیری بهصورت پنهان و غیرمستقیم بروز میکند و شناسایی آن نیازمند تحلیلهای آماری پیچیده است.

گاهی الگوریتمها از متغیرهایی استفاده میکنند که بهطور غیرمستقیم نمایندهی ویژگیهای حساس هستند؛ بدون آنکه این ویژگیها بهصورت صریح در مدل لحاظ شده باشند. این نوع سوگیری بهویژه خطرناک است، زیرا تشخیص آن برای کاربران عادی بسیار دشوار است.

نمونههای واقعی از سوگیری الگوریتمها در جهان

در سالهای اخیر، نمونههای متعددی از سوگیری الگوریتمی توجه پژوهشگران و افکار عمومی را به خود جلب کرده است. گزارشهایی نشان میدهد برخی سیستمهای پیشبینی جرم، افراد متعلق به گروههای خاص نژادی یا اجتماعی را با احتمال بیشتری پرخطر ارزیابی میکنند.

همچنین، برخی الگوریتمهای تبلیغاتی فرصتهای شغلی با درآمد بالا را بیشتر به مردان نمایش دادهاند و یا سیستمهای اعتبارسنجی بانکی شرایط سختتری برای اقلیتها در نظر گرفتهاند. این موارد نشان میدهد که سوگیری الگوریتمی میتواند نابرابریهای موجود را تقویت و بازتولید کند.

پیامدهای اجتماعی، اخلاقی و حقوقی سوگیری الگوریتمی

سوگیری الگوریتمها تنها یک خطای فنی ساده نیست، بلکه پیامدهای اجتماعی و اخلاقی گستردهای به همراه دارد. زمانی که افراد احساس کنند یک سیستم هوش مصنوعی بهطور ناعادلانه با آنها برخورد میکند، اعتماد عمومی به فناوری کاهش مییابد. این بیاعتمادی میتواند مانعی جدی در مسیر پذیرش هوش مصنوعی در جامعه باشد.

از منظر حقوقی نیز، سوگیری الگوریتمی پرسشهای مهمی درباره مسئولیتپذیری ایجاد میکند. در صورت بروز یک تصمیم ناعادلانه، مشخص نیست مسئولیت بر عهده چه کسی است: برنامهنویس، شرکت توسعهدهنده یا نهاد استفادهکننده؟ نبود چارچوبهای قانونی شفاف، این چالش را پیچیدهتر کرده است.

راهکارهای شناسایی و کاهش سوگیری الگوریتمها

۱. شناسایی و اندازهگیری سوگیری الگوریتمی

نخستین گام در مقابله با سوگیری الگوریتمی، شناسایی و اندازهگیری آن است. پژوهشگران از شاخصهای عدالت الگوریتمی، مقایسه نرخ خطا در گروههای مختلف و تحلیل نتایج در سناریوهای گوناگون برای تشخیص سوگیری استفاده میکنند.

۲. بهبود دادهها و طراحی مدلهای منصفانه

جمعآوری دادههای متنوعتر، متوازنتر و نمایندهتر نقش مهمی در کاهش سوگیری دارد. علاوه بر این، توسعه مدلهای توضیحپذیر (Explainable AI) به کاربران و ناظران اجازه میدهد منطق تصمیمگیری الگوریتمها را بهتر درک و در صورت لزوم اصلاح کنند.

۳. پایش مستمر الگوریتمها پس از استقرار

حتی الگوریتمهایی که در مرحله آزمایش عادلانه به نظر میرسند، ممکن است در محیط واقعی دچار سوگیری شوند. بنابراین، پایش مداوم عملکرد سیستمها و بازبینی دورهای آنها از اهمیت بالایی برخوردار است.

آینده هوش مصنوعی و اهمیت عدالت الگوریتمی

آینده هوش مصنوعی به میزان توجه ما به عدالت الگوریتمی وابسته است. اگر توسعه این فناوری بدون در نظر گرفتن پیامدهای اجتماعی و اخلاقی ادامه یابد، خطر آن وجود دارد که هوش مصنوعی به ابزاری برای تثبیت و تشدید نابرابریها تبدیل شود.

در مقابل، اگر پژوهشگران، سیاستگذاران و توسعهدهندگان بهصورت هماهنگ برای طراحی سیستمهای شفاف، پاسخگو و منصفانه تلاش کنند، هوش مصنوعی میتواند به ابزاری قدرتمند برای کاهش تبعیض و ارتقای کیفیت زندگی انسانها بدل شود.

مسئولیت انسانی در برابر سوگیری الگوریتمها

در نهایت، سوگیری الگوریتمها یادآور این حقیقت است که فناوری هرگز جدا از زمینه اجتماعی خود عمل نمیکند. هوش مصنوعی بازتابی از دادهها، ارزشها و تصمیمهای انسانی است. بنابراین، استفاده عادلانه و اخلاقی از آن یک تعهد فنی صرف نیست، بلکه مسئولیتی انسانی، اجتماعی و اخلاقی به شمار میآید. توجه جدی به مسئله سوگیری الگوریتمی میتواند مسیر آینده هوش مصنوعی را به شکلی پایدارتر، عادلانهتر و انسانیتر رقم بزند.

پستهای مرتبط

با آخرین و مهمترین اخبار بهروز بمانید

You need to configure your Mailchimp API key for this form to work properly.